Überblick

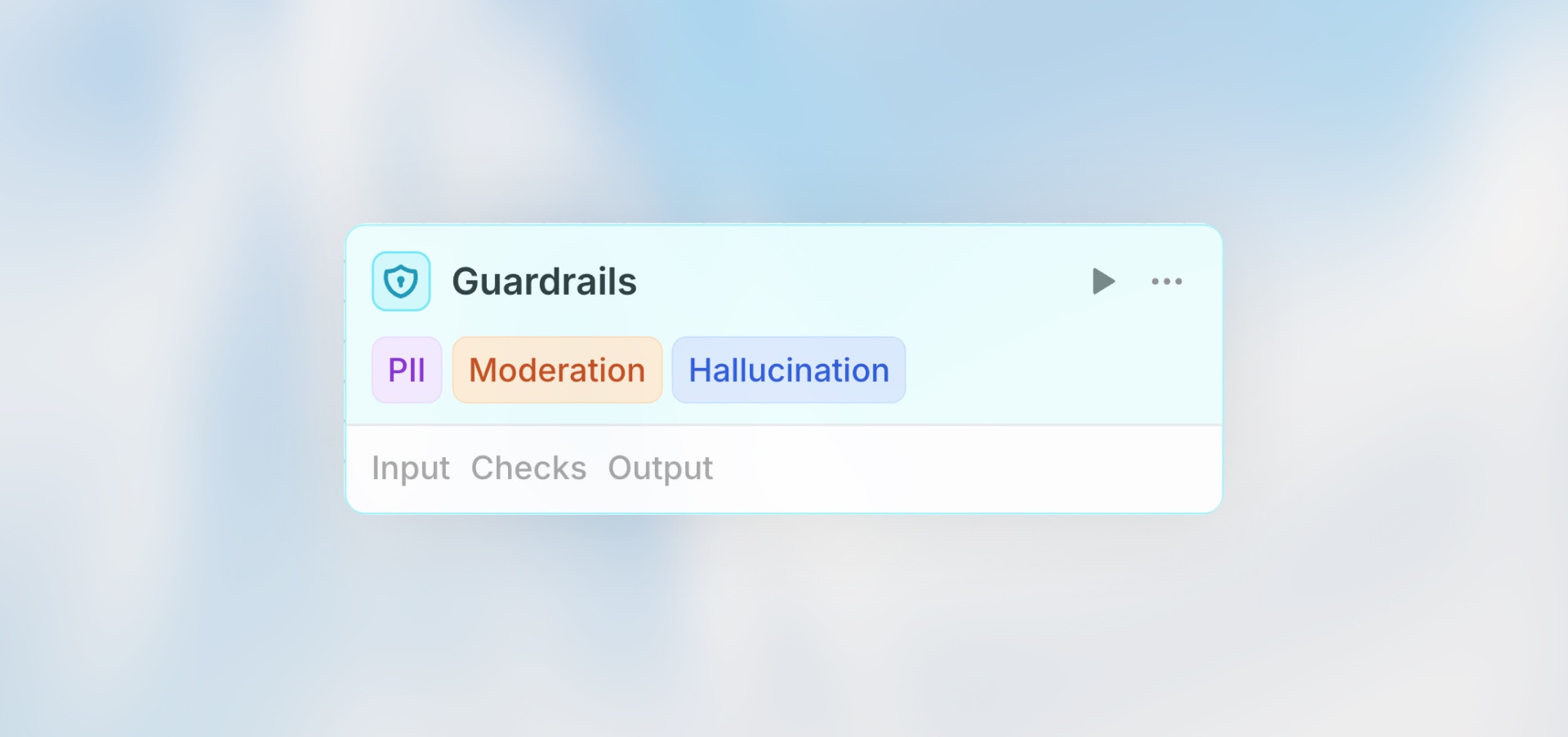

Der Guardrails-Node validiert Inhalte mit KI-gestützten Checks, um Sicherheit, Genauigkeit und Compliance zu gewährleisten. Jeder Guardrail verwendet ein LLM als Richter zur Bewertung deines Inputs gegen spezifische Kriterien und lässt den Workflow fehlschlagen, wenn Vertrauensschwellen überschritten werden.Am besten für: Content-Moderation, PII-Erkennung, Halluzinations-Checks, Jailbreak-Prävention und benutzerdefinierte Validierungsregeln.

Wie es funktioniert

- Stelle zu validierenden Input-Content bereit (von vorherigen Nodes)

- Aktiviere spezifische Guardrail-Checks

- Setze Vertrauensschwelle für jeden Check (0-1)

- Wähle KI-Modell für Bewertung

- Wenn ein Check die Schwelle überschreitet → Node schlägt fehl und markiert das Problem

Konfiguration

Input

Der Inhalt, den du validieren möchtest. Unterstützt Manual-, Auto- und Prompt-AI-Modi. Beispiel:Modell-Auswahl

Wähle das KI-Modell, das zur Bewertung aller aktivierten Guardrails verwendet wird. Leistungsfähigere Modelle bieten genauere Erkennung, kosten aber mehr.Verfügbare Guardrails

Personally Identifiable Information (PII)

Erkennt persönliche Informationen wie Namen, E-Mails, Telefonnummern, Adressen, Sozialversicherungsnummern, Kreditkarten, etc. Wann verwenden:- Bevor benutzergenerierte Inhalte gespeichert werden

- Beim externen Teilen von Daten

- Compliance-Anforderungen (GDPR, HIPAA)

- Kundenservice-Workflows

- Vertrauensschwelle: 0.7 (empfohlen)

- Höhere Schwelle = strengere Erkennung

Moderation

Prüft auf unangemessene, schädliche oder beleidigende Inhalte einschließlich Hassrede, Gewalt, Erwachseneninhalte, Belästigung, etc. Wann verwenden:- Benutzergenerierte Content-Plattformen

- Öffentlich sichtbare Kommunikation

- Community-Moderation

- Kundenbezogene Outputs

- Vertrauensschwelle: 0.6 (empfohlen)

- Passe basierend auf deinen Content-Richtlinien an

Jailbreak-Erkennung

Identifiziert Versuche, KI-Sicherheitskontrollen zu umgehen oder die KI zu unbeabsichtigten Verhaltensweisen zu manipulieren. Wann verwenden:- Verarbeitung von Benutzer-Prompts vor dem Senden an KI

- Öffentliche KI-Schnittstellen

- Workflows mit vom Benutzer bereitgestellten Anweisungen

- Sicherheitssensible Anwendungen

- Vertrauensschwelle: 0.7 (empfohlen)

- Höhere Schwelle für weniger False Positives

Halluzinations-Erkennung

Erkennt, wenn KI-generierte Inhalte falsche oder nicht verifizierbare Informationen enthalten. Wann verwenden:- Faktenbasierte Content-Generierung

- Kundenservice-Antworten

- Finanz- oder medizinische Informationen

- Jeder Workflow, bei dem Genauigkeit kritisch ist

- Vertrauensschwelle: 0.6 (empfohlen)

- Erfordert Referenzdaten zum Vergleich

Benutzerdefinierte Bewertung

Definiere deine eigenen Validierungskriterien mit natürlichsprachlichen Anweisungen. Wann verwenden:- Domänenspezifische Validierung

- Brand-Voice-Compliance

- Benutzerdefinierte Geschäftsregeln

- Spezialisierte Content-Anforderungen

- Bewertungskriterien: Beschreibe, wonach geprüft werden soll

- Vertrauensschwelle: Setze basierend auf benötigter Strenge

Vertrauensschwellen setzen

Die Vertrauensschwelle bestimmt, wie streng jeder Check ist:| Schwelle | Verhalten | Verwenden, wenn |

|---|---|---|

| 0.3-0.5 | Nachsichtig | False Positives vermeiden, nur informativ |

| 0.6-0.7 | Ausgewogen | Die meisten Anwendungsfälle, gute Genauigkeit |

| 0.8-0.9 | Streng | Hochrisiko-Szenarien, kritische Validierung |

| 0.9-1.0 | Sehr streng | Nur sehr offensichtliche Verstöße markieren |

Beispiel-Workflows

Content-Moderations-Pipeline

KI-Antwort-Validierung

Multi-Check-Validierung

Fehler behandeln

Wenn ein Guardrail-Check fehlschlägt, stoppt der Workflow am Guardrails-Node. Du kannst Fehlerbehandlung konfigurieren, um zu alternativen Pfaden zu routen, Benachrichtigungen zu senden oder Fallback-Aktionen zu triggern.Wann jeden Guardrail verwenden

PII-Erkennung

PII-Erkennung

Verwende PII-Erkennung für:

- Öffentliche Inhalte, die keine persönlichen Informationen enthalten sollten

- Daten, die an Dritte oder externe Systeme gesendet werden

- Compliance-sensitive Workflows (GDPR, HIPAA, etc.)

- Verhinderung versehentlicher Offenlegung sensibler Benutzerdaten

Moderation

Moderation

Verwende Moderation für:

- Benutzergenerierte Inhalte, die Überprüfung benötigen

- Öffentlich sichtbare Outputs und Kommunikation

- Community-Plattformen und Foren

- Filtern unangemessener oder schädlicher Inhalte

Jailbreak-Erkennung

Jailbreak-Erkennung

Verwende Jailbreak-Erkennung für:

- Vom Benutzer bereitgestellte Prompts oder Anweisungen an KI

- Öffentliche KI-Schnittstellen, die für externe Benutzer zugänglich sind

- Sicherheitskritische Anwendungen, bei denen Prompt-Manipulation ein Risiko ist

- Schutz vor Versuchen, Systemeinschränkungen zu umgehen

Halluzinations-Erkennung

Halluzinations-Erkennung

Verwende Halluzinations-Erkennung für:

- Faktenbasierte Content-Generierung, die Genauigkeit erfordert

- Kundenservice-Antworten mit spezifischen Informationen

- Finanz- oder medizinische Informationen, bei denen Genauigkeit kritisch ist

- Jeder Inhalt, bei dem falsche Informationen Schaden verursachen könnten

Benutzerdefinierte Bewertung

Benutzerdefinierte Bewertung

Verwende benutzerdefinierte Bewertung für:

- Marken-Compliance und Tone-of-Voice-Richtlinien

- Domänenspezifische Regeln und Industriestandards

- Qualitätsstandards, die für deine Organisation einzigartig sind

- Geschäftsspezifische Anforderungen, die nicht von anderen Guardrails abgedeckt werden

Best Practices

Aktiviere mehrere Checks

Aktiviere mehrere Checks

Verwende mehrere Guardrails zusammen für umfassende Validierung. PII + Moderation ist eine häufige Kombination.

Beginne mit ausgewogenen Schwellen

Beginne mit ausgewogenen Schwellen

Beginne mit 0.7 und passe basierend auf Ergebnissen an. Zu niedrig = False Positives, zu hoch = verpasste Probleme.

Handle Fehler immer

Handle Fehler immer

Lass den Workflow nicht einfach fehlschlagen—füge Fehlerpfade hinzu, um Teams zu benachrichtigen, Verstöße zu loggen oder alternative Aktionen zu triggern.

Teste mit Edge-Cases

Teste mit Edge-Cases

Teste Guardrails mit Grenzfall-Inhalten, um Schwellen korrekt zu kalibrieren.

Verwende geeignete Modelle

Verwende geeignete Modelle

Leistungsfähigere Modelle (GPT-4) bieten bessere Erkennung, kosten aber mehr. Balanciere Genauigkeitsbedürfnisse mit Budget.

Dokumentiere benutzerdefinierte Bewertungen

Dokumentiere benutzerdefinierte Bewertungen

Schreibe klare, spezifische Kriterien für benutzerdefinierte Bewertungen, damit die KI genau versteht, was zu prüfen ist.